Todo sobre el frame loop

Recientemente, publiqué la realidad virtual llega a la web, un post que presenta conceptos básicos detrás de la API de dispositivo WebXR. Además proporcioné instrucciones para solicitar, acceder y culminar una sesión de XR.

Este post describe el bucle de tramas, que es un bucle infinito controlado por el usuario-agente en el que el contenido se dibuja repetidamente en la pantalla. El contenido se dibuja en bloques discretos llamados marcos. La sucesión de fotogramas crea la ilusión de movimiento.

Que no es este articulo

WebGL y WebGL2 son los únicos medios para representar contenido durante un bucle de cuadro en una aplicación WebXR. Por suerte, muchos marcos proporcionan una capa de abstracción al mismo tiempo de WebGL y WebGL2. Dichos marcos incluyen three.js,

babylonjsy

PlayCanvas, mientras Un cuadro y

Reaccionar 360 están diseñados para interactuar con WebXR.

Este post no es un tutorial de WebGL ni de framework. Explica los conceptos básicos de un bucle de fotogramas usando la muestra de sesión de realidad virtual inmersiva del Grupo de trabajo web inmersivo (manifestación,

fuente). Si desea sumergirse en WebGL o en uno de los marcos, Internet proporciona una lista creciente de posts.

Los jugadores y el juego

Cuando trataba de comprender el bucle de cuadros, seguía perdiéndome en los detalles. Hay muchos objetos en juego, y algunos de ellos solo se nombran por propiedades de referencia en otros objetos. Para ayudarte a mantenerlo claro, describiré los objetos, a los que llamo «jugadores». Posteriormente describiré cómo interactúan, a lo que llamo «el juego».

Los jugadores

XRViewerPose

Una pose es la posición y orientación de algo en el espacio 3D. Tanto los espectadores como los dispositivos de entrada disponen una pose, pero lo que nos preocupa aquí es la pose del espectador. Ambas poses de visor y dispositivo de entrada disponen transform atributo que describe su posición como vector y su orientación como un cuaternión relativo al origen. El origen se especifica en función del tipo de espacio de referencia solicitado al llamar XRSession.requestReferenceSpace().

Los espacios de referencia tardan un poco en explicarse. Los cubro en profundidad en realidad aumentada. La muestra que estoy utilizando como base para este post utiliza un 'local' espacio de referencia, lo que significa que el origen está en la posición del espectador en el momento de la creación de la sesión sin un piso bien definido, y su posición precisa puede variar según la plataforma.

XRView

Una vista corresponde a una cámara que visualiza la escena virtual. Una vista además cuenta con una

transform atributo que describe su posición como vector y su orientación. Estos se proporcionan como un par de vector / cuaternión y como una matriz idéntico, puede utilizar cualquiera de las representaciones dependiendo de cuál se ajuste mejor a su código. Cada vista corresponde a una pantalla o una parte de una pantalla utilizada por un dispositivo para presentar imágenes al espectador. XRView los objetos se devuelven en una matriz desde el XRViewerPose objeto. El número de vistas de la matriz varía. En los dispositivos móviles, una escena de RA cuenta con una vista, que puede o no cubrir la pantalla del dispositivo. Los auriculares suelen tener dos vistas, una para cada ojo.

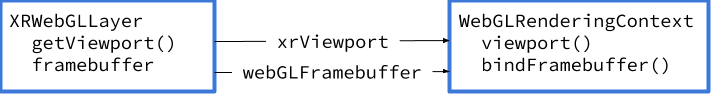

XRWebGLLayer

Las capas proporcionan una fuente de imágenes de mapa de bits y descripciones de cómo se deben representar esas imágenes en el dispositivo. Esta descripción no captura lo que hace este jugador. He llegado a pensar en ello como un intermediario entre un dispositivo y un

WebGLRenderingContext. MDN tiene el mismo punto de vista, afirmando que «proporciona un vínculo» entre los dos. Como tal, proporciona acceso a los otros jugadores.

En general, los objetos WebGL almacenan información de estado para renderizar gráficos 2D y 3D.

WebGLFramebuffer

Un framebuffer proporciona datos de imagen al WebGLRenderingContext. Posteriormente de recuperarlo del XRWebGLLayer, básicamente pásalo a la corriente

WebGLRenderingContext. Aparte de llamar bindFramebuffer() (más sobre eso más adelante) nunca accederá a este objeto de forma directa. Básicamente lo pasará del XRWebGLLayer al WebGLRenderingContext.

XRViewport

Una ventana gráfica proporciona las coordenadas y dimensiones de una región rectangular en la WebGLFramebuffer.

WebGLRenderingContext

Un contexto de representación es un punto de acceso programático para un lienzo (el espacio en el que estamos dibujando). Para hacer esto, requiere un WebGLFramebuffer y un XRViewport.

Note la vinculación entre XRWebGLLayer y WebGLRenderingContext. Uno corresponde al dispositivo del espectador y el otro corresponde a la página web.

WebGLFramebuffer y XRViewport se pasan del primero al segundo.

La vinculación entre XRWebGLLayer y WebGLRenderingContext

El juego

Ahora que sabemos quiénes son los jugadores, veamos el juego que juegan. Es un juego que comienza de nuevo con cada fotograma. Recuerde que los fotogramas son parte de un bucle de fotogramas que surge a una velocidad que depende del hardware subyacente. Para las aplicaciones de realidad virtual, los fps pueden oscilar entre 60 y 144. AR para Android se ejecuta a 30 fps. Su código no debe hacerse cargo ninguna velocidad de fotogramas en particular.

El procedimiento básico para el bucle de cuadro se ve así:

- Llamada

XRSession.requestAnimationFrame(). En respuesta, el agente de usuario invoca elXRFrameRequestCallback, que usted establece. - Dentro de su función de devolución de llamada:

- Llamada

XRSession.requestAnimationFrame()de nuevo. - Obtén la pose del espectador.

- Pase (‘vincular’) el

WebGLFramebufferdesde elXRWebGLLayeralWebGLRenderingContext. - Itera sobre cada

XRViewobjeto, recuperando suXRViewportdesde elXRWebGLLayery pasárselo alWebGLRenderingContext. - Dibuja algo en el framebuffer.

- Llamada

Como los pasos 1 y 2a se trataron en el post anterior, comenzaré en el paso 2b.

Obtén la pose del espectador

Probablemente no es necesario decirlo. Para dibujar cualquier cosa en AR o VR, necesito saber dónde está el espectador y hacia dónde está mirando. La posición y la orientación del espectador son proporcionadas por un Objeto XRViewerPose. Obtengo la pose del espectador llamando XRFrame.getViewerPose() en el cuadro de animación actual. Le paso el espacio de referencia que adquirí cuando configuré la sesión. Los valores devueltos por este objeto siempre son relativos al espacio de referencia que solicité cuando entré a la sesión actual. Como recordarás, tengo que pasar el espacio de referencia actual al solicitar la pose.

function onXRFrame(hrTime, xrFrame) {

let xrSession = xrFrame.session;

xrSession.requestAnimationFrame(onXRFrame);

let xrViewerPose = xrFrame.getViewerPose(xrRefSpace);

if (xrViewerPose) {

}

}Hay una pose del espectador que representa la posición general del usuario, dicho de otra forma, la cabeza del espectador o la cámara del teléfono en el caso de un teléfono inteligente. La pose le dice a su aplicación dónde está el espectador. Usos reales de renderizado de imágenes

XRView objetos, a los que llegaré en un momento.

Antes de continuar, pruebo si la pose del espectador fue devuelta en caso de que el sistema pierda el seguimiento o bloquee la pose por razones de privacidad. El seguimiento es la capacidad del dispositivo XR para comprender dónde está y / o sus dispositivos de entrada en vinculación con el entorno. El seguimiento se puede perder de varias formas y varía según el método utilizado para realizar el seguimiento. A modo de ejemplo, si se usan cámaras en los auriculares o en el teléfono para rastrear, el dispositivo puede perder su capacidad para establecer dónde se encuentra en situaciones con poca luz o sin luz, o si las cámaras están cubiertas.

Un ejemplo de bloqueo de la pose por motivos de privacidad es que si el auricular muestra un cuadro de diálogo de seguridad, como una solicitud de permiso, el navegador puede dejar de proporcionar poses a la aplicación mientras esto ocurre. Pero ya llamé

XRSession.requestAnimationFrame() de modo que si el sistema puede recuperarse, el bucle de tramas continuará. Caso contrario, el agente de usuario finalizará la sesión y llamará al

end controlador de eventos.

Un pequeño desvío

El paso siguiente necesita objetos creados durante la configuración de la sesión. Recuerde que creé un lienzo y le indiqué que creara un contexto de representación Web GL compatible con XR, que obtuve llamando canvas.getContext(). Todo el dibujo se realiza a través de la API de WebGL, la API de WebGL2 o un marco basado en WebGL como Three.js. Este contexto se pasó al objeto de sesión a través de updateRenderState(), junto con una nueva instancia de XRWebGLLayer.

let canvas = document.createElement('canvas');

let webGLRenContext = canvas.getContext('webgl', { xrCompatible: true });

xrSession.updateRenderState({

baseLayer: new XRWebGLLayer(xrSession, webGLRenContext)

});

Pase (‘vincular’) el WebGLFramebuffer

los XRWebGLLayer proporciona un framebuffer para el WebGLRenderingContext

proporcionado específicamente para su uso con WebXR y reemplazando el framebuffer predeterminado de los contextos de representación. A esto se le llama «vinculante» en el lenguaje de WebGL.

function onXRFrame(hrTime, xrFrame) {

let xrSession = xrFrame.session;

xrSession.requestAnimationFrame(onXRFrame);

let xrViewerPose = xrFrame.getViewerPose(xrRefSpace);

if (xrViewerPose) {

let glLayer = xrSession.renderState.baseLayer;

webGLRenContext.bindFramebuffer(webGLRenContext.FRAMEBUFFER, glLayer.framebuffer);

}

}Iterar sobre cada objeto XRView

Posteriormente de conseguir la pose y vincular el framebuffer, es hora de conseguir las ventanas gráficas. los XRViewerPose contiene una matriz de interfaces XRView, cada una de las cuales representa una pantalla o una parte de una pantalla. Contienen información necesaria para representar contenido que está correctamente posicionado para el dispositivo y el espectador, como el campo de visión, el desplazamiento del ojo y otras propiedades ópticas. Como dibujo para dos ojos, tengo dos vistas, que recorro en bucle y dibujo una imagen separada para cada una.

Al poner en práctica para la realidad aumentada basada en teléfonos, solo tendría una vista, pero todavía usaría un bucle. Aún cuando puede parecer inútil iterar a través de una vista, hacerlo le posibilita tener una única ruta de renderizado para un espectro de experiencias inmersivas. Esta es una diferencia importante entre WebXR y otros sistemas inmersivos.

function onXRFrame(hrTime, xrFrame) {

let xrSession = xrFrame.session;

xrSession.requestAnimationFrame(onXRFrame);

let xrViewerPose = xrFrame.getViewerPose(xrRefSpace);

if (xrViewerPose) {

let glLayer = xrSession.renderState.baseLayer;

webGLRenContext.bindFramebuffer(webGLRenContext.FRAMEBUFFER, glLayer.framebuffer);

for (let xrView of xrViewerPose.views) {

}

}

}Pase el objeto XRViewport al WebGLRenderingContext

Un XRView objeto se refiere a lo que se puede observar en una pantalla. Pero para dibujar en esa vista, necesito coordenadas y dimensiones que sean específicas de mi dispositivo. Del mismo modo que con el framebuffer, los solicito al XRWebGLLayer y pasarlos al

WebGLRenderingContext.

function onXRFrame(hrTime, xrFrame) {

let xrSession = xrFrame.session;

xrSession.requestAnimationFrame(onXRFrame);

let xrViewerPose = xrFrame.getViewerPose(xrRefSpace);

if (xrViewerPose) {

let glLayer = xrSession.renderState.baseLayer;

webGLRenContext.bindFramebuffer(webGLRenContext.FRAMEBUFFER, glLayer.framebuffer);

for (let xrView of xrViewerPose.views) {

let viewport = glLayer.getViewport(xrView);

webGLRenContext.viewport(viewport.x, viewport.y, viewport.width, viewport.height);

}

}

}El webGLRenContext

Al escribir este post, tuve un debate con algunos colegas sobre el nombre del webGLRenContext objeto. Los scripts de muestra y la mayoría del código WebXR básicamente llaman a esta variable gl. Cuando estaba trabajando para saber las muestras, seguía olvidando lo que gl referido a. Lo he llamado webGLRenContext para recordarle mientras aprende que este es un ejemplo de WebGLRenderingContext.

La razón es que utilizar gl posibilita que los nombres de los métodos se parezcan a sus contrapartes en la API de OpenGL ES 2.0, que se usa para crear realidad virtual en lenguajes compilados. Este hecho es obvio si ha escrito aplicaciones de realidad virtual utilizando OpenGL, pero confuso si es absolutamente nuevo en esta tecnología.

Dibuja algo en el framebuffer

Si se siente verdaderamente ambicioso, puede utilizar WebGL de forma directa, pero no lo recomiendo. Es mucho más sencillo usar uno de los marcos enumerados en la parte superior.

Conclusión

Este no es el final de las actualizaciones o posts de WebXR. Puedes hallar un referencia para todas las interfaces y miembros de WebXR

en MDN. Para conocer las próximas mejoras de las interfaces, siga las características individuales en Estado de Chrome.

Foto por JESHOOTS.COM en Unsplash