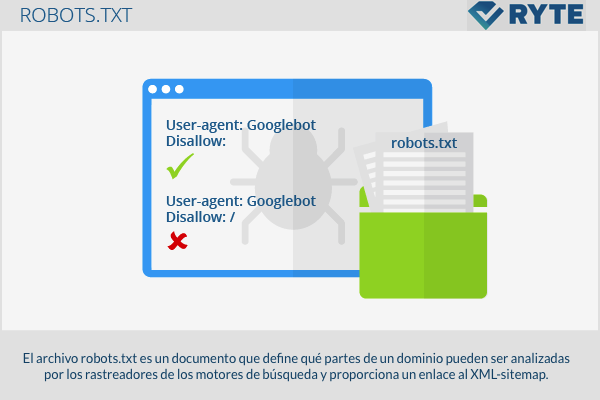

le fichier robots.txt est un document qui établit quelles parties d'un domaine peuvent être analysées par les robots des moteurs de recherche et fournit un lien vers le Plan du site XML.

Structure

L'appel "Protocole standard d'exclusion des robots", Protocole standard pour les exclusions de robots, a été publié pour la première fois en 1994. Ce protocole définit que les robots des moteurs de recherche doivent trouver et lire le fichier nommé "Robots.txt" avant de commencer l'indexation. C'est pourquoi il doit être placé dans le répertoire racine du domaine. Malgré tout, il faut se rappeler que tous les trackers ne suivent pas cette même règle et donc, le "Robots.txt" ils ne promettent pas l'accès 100% et la protection de la vie privée. Certains moteurs de recherche indexent toujours les pages bloquées et affichent même celles sans description dans les SERPs. C'est particulièrement le cas des sites Web contenant trop de liens. Quoi qu'il en soit, les principaux moteurs de recherche comme Google, Yahoo y Bing oui ils sont conformes aux règles du protocole "Robots.txt".

Création et contrôle du "robots.txt"

Il est simple de créer un "Robots.txt" à l'aide d'un éditeur de texte. Dans le même temps, vous pouvez trouver des outils gratuits sur Internet qui offrent des informations détaillées sur la façon de générer un fichier. "Robots.txt" ou qu'ils le créent même automatiquement pour vous. Chaque fichier contient 2 blocs. Dans le premier, il est spécifié pour quels utilisateurs les instructions sont valables. Dans le deuxième bloc, les instructions sont écrites, appelées "Refuser", avec la liste des pages à exclure. Il est recommandé de vérifier soigneusement que le fichier a été correctement écrit avant de le télécharger dans le répertoire car, avec essentiellement une petite erreur de syntaxe, vous pouvez mal interpréter les instructions et les pages d'index qui, en théorie, ne devraient pas apparaître dans les résultats de la recherche. Pour vérifier si le fichier "Robots.txt" fonctionne correctement, vous pouvez utiliser l'outil webmaster de Google et effectuer une analyse sur "l'état" -> "URL bloquées".

Exclusion de pages

La structure la plus simple d'un fichier robots.txt apparaît comme suit:

User-agent: Googlebot Disallow:

Ce code permet à Googlebot d'analyser toutes les pages. Le contraire, comme l'interdiction complète du portail Web, s'écrit comme suit: '

User-agent: Googlebot Disallow:

Dans la ligne "User-agent", l'utilisateur écrit à qui il est adressé. Les termes suivants peuvent être utilisés:

- Googlebot (moteur de recherche Google)

- Googlebot-Image (recherche d'images Google)

- Adsbot-Google (Google AdWords)

- Slurp (Yahoo)

- bingbot (Bing)

Si la commande est adressée à différents utilisateurs, chaque robot aura sa propre ligne. Au mindshape.de vous pourrez trouver un récapitulatif des commandes et paramètres les plus courants pour créer un robots.txt. De plus, un lien vers un plan de site XML peut être ajouté comme suit:

Plan du site: http://www.domain.de/sitemap.xm

Exemple

# robots.txt pour http://www.example.com/ User-agent: UniversalRobot / 1.0 User-agent: my-robot Disallow: / sources / dtd / User-agent: * Disallow: / nonsense / Disallow: / temp / Disallow: /newsticker.shtml

Pertinence pour le référencement

L'utilisation du protocole robots.txt influence l'accès des robots d'exploration au portail Web. Il existe deux commandes différentes: "Autoriser" et "interdire". Il est très important d'utiliser correctement ce protocole car si le webmaster bloque par erreur - au moyen de la commande "disallow" - des fichiers et contenus importants du portail web, les robots d'exploration ne pourront pas le lire ou l'indexer. Quoi qu'il en soit, s'ils sont utilisés correctement, les webmasters sont en mesure d'informer les robots d'exploration sur la manière de revoir la structure interne de leur portail Web.

liens web

- Informations sur les fichiers robots.txt support.google.com

- Fichier Robots.txt: qu'est-ce que c'est, à quoi ça sert et comment le créer Blog ignaciosantiago.com